一個只見過文本的大語言模型(LLM),在從未直接看過圖像的情況下,竟然能學到可遷移到視覺任務的先驗能力 —— 這是 Meta Superintelligence Labs 與牛津團隊新論文的發現。

近日,Meta 超級智能實驗室(Meta Superintelligence Labs)與牛津大學的研究者發布了一篇長達 33 頁的重磅論文,通過超過 100 組受控實驗、耗費 50 萬 GPU 小時的龐大研究,系統性地揭開了 LLM 視覺先驗的來源。 作者提出,視覺先驗可分為「推理先驗」和「感知先驗」,并給出了一套預訓練的數據混合配方,用于在只用文本預訓練階段就「播下」視覺能力的種子。

這項研究不僅解釋了 LLM 無師自通學會看的秘密,更提出了一套預訓練的數據配方,旨在從語言預訓練階段就有意地培養模型的視覺能力,為下一代更強大的多模態大模型鋪平道路。

- 論文標題:Learning to See Before Seeing: Demystifying LLM Visual Priors from Language Pre-training

- 論文鏈接:https://arxiv.org/pdf/2509.26625

- 項目地址:

- https://junlinhan.github.io/projects/lsbs/

核心洞察:LLM 視覺先驗并非鐵板一塊,源于兩種獨立的「先驗知識」

研究最重要的發現是,LLM 從語言中獲得的「視覺先驗」(Visual Priors)并非單一的能力,而是可以分解為兩種來源和特性截然不同的部分:

- 推理先驗 (Reasoning Prior):一種更抽象、跨模態的通用能力。它主要通過預訓練以推理為中心的數據(如代碼、數學、學術論文)來獲得。就像人類通過學習邏輯和數學來構建推理框架一樣,LLM 通過學習這些結構化文本,掌握了可遷移的、普適的推理能力,這種能力可以直接應用于解決復雜的視覺問題。

- 感知先驗 (Perception Prior):這更側重于對具體視覺概念的認知,比如識別物體的顏色、形狀和名稱。這種能力并非來自某一特定類型的數據,而是從廣泛、多樣的通用語料(如網頁抓取)中「彌散式」地浮現出來。多模態大模型的感知能力對視覺指令微調和所選用的視覺編碼器更為敏感。

關鍵發現:少量視覺描述就夠,海量推理數據是關鍵

大量實驗:系統性揭秘 LLM 的視覺先驗

團隊進行了一系列精巧的實驗,實驗采用常見的 adapter-style 多模態適配流程 —— 先在只讀文本的基礎上預訓練多種解碼器式 LLM(沿用 Llama-3 風格架構,模型尺度從 340M 到 13B 不等,核心對比以 3B/7B 模型 為主),然后用同樣的「視覺對齊 + 監督微調」的兩階段流程把視覺能力接入來衡量視覺先驗,得出了 6 個結論并引入 3 個假設,這里節選:

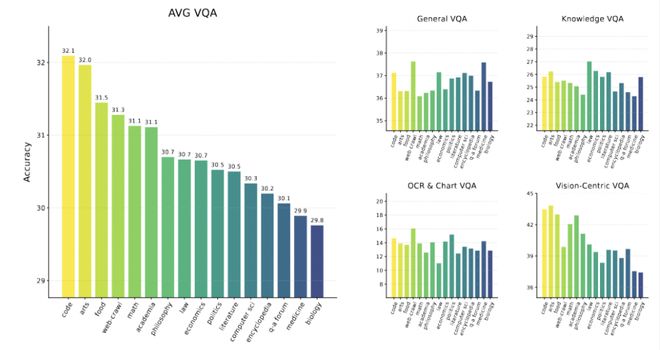

- 能力的起源有跡可循:通過對 16 種不同單一數據源的獨立訓練,研究發現,在「代碼」「數學」和「學術」數據上訓練的模型,在需要抽象推理的視覺任務(Vision-Centric VQA)上表現最好。

- 推理數據多多益善,視覺數據很快飽和:實驗表明,在預訓練數據中,不斷增加推理密集型文本(如代碼)的比例,模型的下游視覺推理能力會持續、顯著地提升,直到占比達到 75% 左右。與此形成鮮明對比的是,描述視覺世界的文本(如描述顏色、形狀、位置的文字)雖然重要,但其效果會迅速飽和。只需一小部分這類數據為模型打下基礎,再多就收效甚微了。